Technical Information

意思決定を真に支援するAIを目指して

これからのAIとの付き合い方

人工知能(AI)技術一般について、社会的にさまざまな問題が指摘されていますが、同時にコンピューターサイエンスの分野からはその解決策が提案され続けています。本稿では、「説明可能AI」「公平性配慮型機械学習」といった先端的な技術開発の方向性を紹介すると同時に、今後のAIが流通する社会で求められる技術との付き合い方をご紹介します。

株式会社富士通研究所

人工知能研究所

トラステッドAIプロジェクト

中尾 悠里 氏

AI技術が人間の意思決定に対してもたらす問題

現在、AI技術は我々の生活に無くてはならないものになっています。しかし、同時にさまざまな問題が指摘されています。その中には技術的な限界だけではなく、社会との接点におけるトピックも挙げられます。代表的なものとして、AI技術によって人間の思考が誘導されるという問題があります。フィルターバブル ※1やソーシャルエコーチェンバー ※2といった用語で指摘されているもので、AI技術を使った検索や推薦では、検索結果や推薦内容にユーザー自身の社会的な偏向が反映され、偏ったコンテンツだけが提示されるという現象を指します。我々が日常的に利用する検索エンジン、動画サイト、SNSといったサービスは裏で機械学習を利用したシステムが機能し、ユーザーの利用履歴から学習を行い、ユーザーが見たいであろうコンテンツを提示するように設計されています。そのため、ユーザーの嗜好を深く学習したシステムでは、次第にユーザーに都合のいい情報しか出なくなります。しかも検索エンジンなどのサービスのインターフェイスは、複雑な手順をなくし、使い慣れた操作で済む心理障壁を下げる設計がされているため、ユーザー自身がこの思考の誘導に気付くことはほとんどありません。

次に、AIのモデルが性差別や人種差別といった差別的なバイアス(男性、白人といったある属性値に出力が偏ってしまうこと)を持った結果を出してしまう問題があります。過去、Googleの検索やアメリカの司法の文脈などで指摘されてきました。例えば、Googleの検索窓にアフリカ系の名前を入れると、その人に全く逮捕歴がなくても逮捕歴に関する結果がサジェストされてしまうという事例があります。

その他にも、2016年にアメリカにおいて、一度刑務所に入った犯罪者を保釈するかどうかを決定する際に再犯予測を行うCOMPASという機械学習ベースのシステムに人種差別的なバイアスがあることが指摘されました。同じ条件の人であれば、白人より黒人の再犯率を高く見積もってしまうというバイアスです。これらのバイアスは、データを基にしたAIを用いて意思決定を支援するというアプローチにおいて、過去の意思決定を集約した教師データをAIに学習させていることに起因します。教師データの中には社会的に行われてきた差別の結果が反映されてしまっているため、そのデータを用いて学習を行うことで、新たな意思決定を行うための機械学習モデルに差別的な偏向が含まれることになります。AIによる差別は主に欧米で指摘されている問題ですが、日本においても就職時や大学入試における男女差別が指摘されており、機械学習ベースの意思決定支援システムが広がれば広がるほど、顕在化する問題だと思われます。

※1:「インターネットの検索サイトが提供するアルゴリズムが、各ユーザーが見たくないような情報を遮断する機能」(フィルター)のせいで、まるで「泡」(バブル)の中に包まれたように、自分が見たい情報しか見えなくなること。(「フィルターバブル」『フリー百科事典 ウィキペディア日本語版』より)

※2:閉鎖的空間内でのコミュニケーションを繰り返すことよって、特定の信念が増幅または強化される状況の比喩である。(「エコーチェンバー現象」『フリー百科事典 ウィキペディア日本語版』より)

AIと社会の接点に関する問題への技術的解決策

上記で指摘された誘導的な判断や差別的な判断を是正する工学的な試みをを二つ紹介します。

説明可能AI(XAI)

思考や行動の誘導のようにAI技術が人間に与える暗黙的な影響を是正するための取り組みとして、AIが出した結果を人間に対して説明可能

(Explainable)にしようとする説明可能なAI(Explainable AI, XAI)の研究が挙げられます。この分野では、画像認識において画像のどの部分がAIの認識に効果を持つか、データのどの特徴量(あるデータを構成する特徴のこと)が分析結果に寄与しているかを説明する技術などが特に有名です。

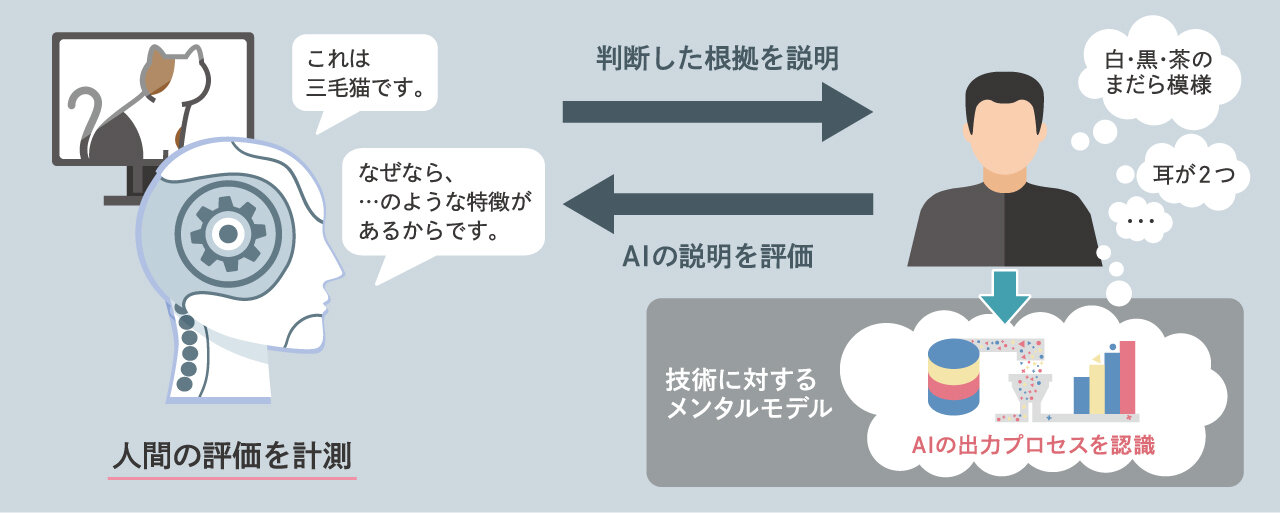

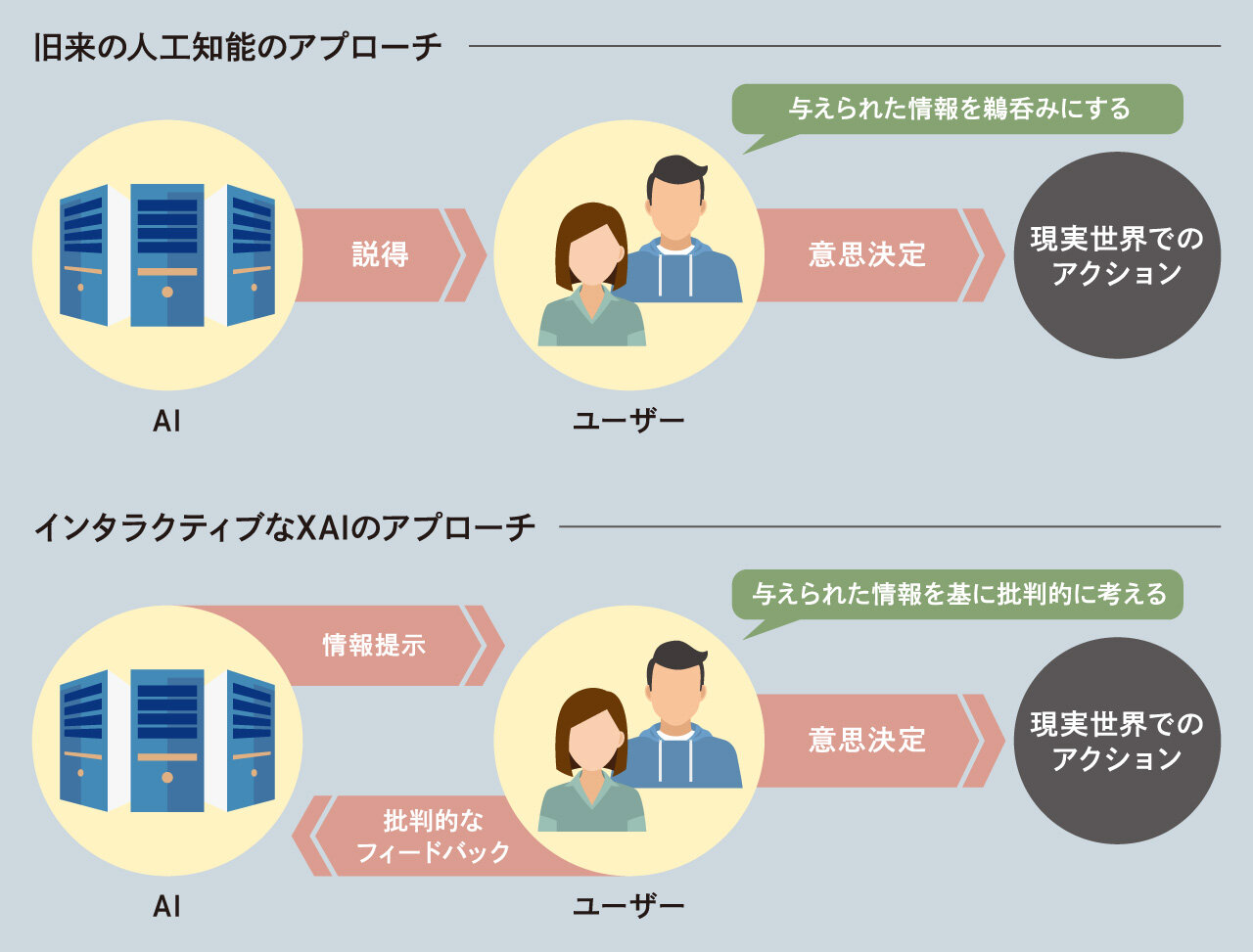

「説明可能AI」の研究は、これまでの精度を競うことを第一目標にしていた工学研究と異なります。説明可能AIの研究において特徴的なことは、AIが出した説明に対し、人間が行う評価自体が技術革新の評価基準となる点です。結果に寄与している特徴量を特定できたとしても、人間とAI技術間の情報の授受を成り立たせるためには、特定した特徴をユーザー自身の判断基準に基づいて認識する必要があります。そのため、出力された説明が人間に適切に認識されたかを評価する必要が生じ、人間側のリアクションを適切に計測する必要が生じます。同時に、AIからの説明を理解するためには、人間側にもAIからの出力がどのようなプロセスで提示されてくるのかといった認識がある程度備わっている必要があります。この認識のことを「技術に対するメンタルモデル」といいます。「説明可能AI」は、理想的にはユーザーがシステムを利用する間に適切なメンタルモデルを構築できるようになっていることが求められています(図1)。

公平性配慮型機械学習

一方で、特に機械学習モデルに関する差別的なバイアスに対して、そもそもAIからの出力自体を公平なものにするために、データやモデルの中に含まれる差別を取り除こうとする「公平性配慮型機械学習」の研究開発が2010年前後から盛んになっています。学術界だけでなく、Google, Microsoft, IBMといった企業が最新の研究成果を公表し続けており、社会における公平性や透明性といった問題を取り扱った国際会議が複数設立され、毎年開催されるようになりました。

「公平性配慮型機械学習」の基本的な前提は、人間が行う意思決定は社会に存在するバイアスから自由ではないということです。公平性配慮型技術を使うことで、差別をなくしたい属性(性別や人種など)を指定しさえすれば、機械的にデータや機械学習のモデルから人種差別や性差別を取り除くことが可能です。これにより、人間の側にあるバイアスをAI技術で正していこうとすることが基本的な方向性です。現在では、さらに発展して、「この技術をどういう文脈で使うべきか?」という文脈での議論が展開されています。例えば、ある属性の人たちに対して、少数派の人を優遇することで、同じくらい優秀である多数派が採用されにくくなる、ということが生じ得ます。優秀な人を採用すべきだという考え方からすると不当ですし、一方で、少数派というだけでこれまで蓄財や教育の機会を奪われてきたという観点からすれば、弱者を是正する改善(アファーマティブアクション)の一環として妥当な処置かもしれません。どのようなポリシーの下で差別を取り除くかについては機械的に決められません。現在では、情報系の学会が主催する国際会議においても、法学者や社会学者、哲学者が入り乱れてどのように技術を使うべきかについての議論を行っている姿が見られます。

しかし、一旦ポリシーを決めてしまえば、AI技術は人間の専門家が行うよりも公平な意思決定を行うことができます。AIは印象や感情で決定を左右されることはないため、ある意味で人間より信頼度の高い意思決定を下すことができるのです。

どちらか一方が正しいわけではない人とAI

「説明可能AI」や「公平性配慮型機械学習」は共に倫理的なAI(Ethical AI)や信頼されるAI(Trusted AI)と呼ばれます。ここまでに紹介した技術において前提となっているのは、AIの出した結果が基本的に正しいということです。そのため、従来では、人の側を評価する際に、どの程度AIの結果を信頼して行動に移れるかということが考慮されてきました。

しかし、実際に意思決定を行わなければならないユーザーの視点に立つと、この前提は適切ではありません。なぜなら、ユーザーに結果を鵜呑みにさせることを前提として開発されたAIは、単に効果的な人間の誘導を狙っていることなります。この狙いはAIからの潜在的な影響を顕在化させて人間にとって自由な意思決定を実現するという目標と矛盾します。

では、AIを信頼せずに人間の思うとおりに意思決定をすればよいのかというと、これも正しくはありません。なぜなら、公平性配慮型機械学習の文脈からすると、人間の意思決定は社会的に望ましくない偏向を含んできた可能性があり、常に信頼のおけるものとは限らないからです。

不可分な合成物であるAIと人間、それをサポートするためのインタラクティブな「説明可能AI」

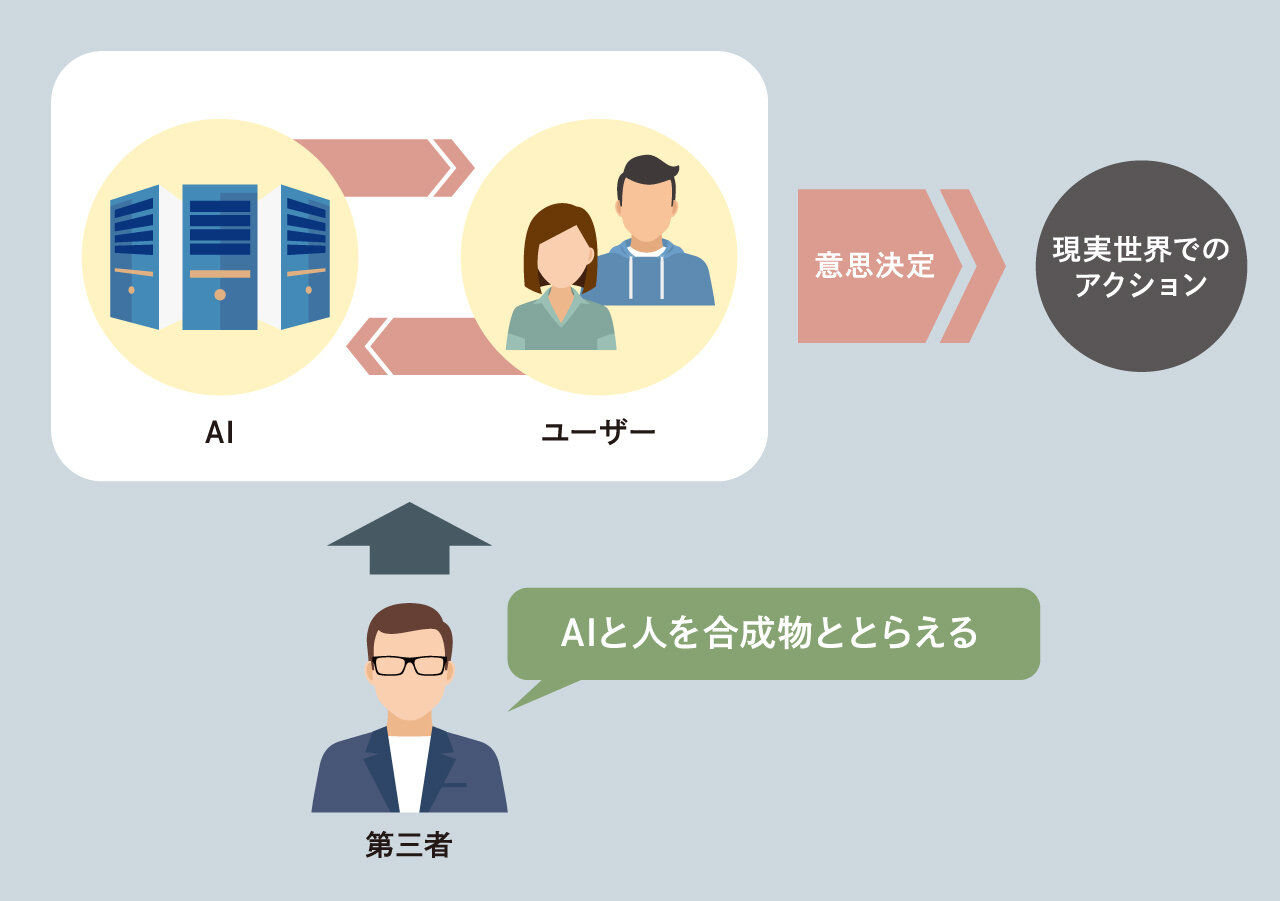

上で述べた人間がAIの誘導から自由になるべきだという考え方と、AIの方が合理的な判断を下せるので信頼すべきだという考え方は一見矛盾します。しかし、二つの考え方はどちらも合理的です。これらの立場を理論的、実践的に統合するために、技術哲学的な意味で第三者的な視点を導入する必要があります。第三者的な視点というのはAIとそれを使っている人間の二者から一歩引いた視点のことです(図2)。

AIは、ユーザーの目線から見ると技術的人工物という他者です。しかし、第三者的な視点から見ると意思決定を共同で行うとき、AIとユーザーは不可分な存在です。ユーザーの立場からするとAIに薦められたから意思決定をしたと感じるかもしれませんが、ユーザーは必ずしもAIが言ったことを鵜呑みにして決定したわけではないはずです。つまり、第三者的な視点に立てば、ユーザーは意思決定を行う際に単に「AI技術の結果から影響を受けた人」というだけの存在ではありません。AIのサポートを受けて行った意思決定はAIだけで行った決定でもないし、ユーザーがひとりで行った決定というわけでもないという意味で、近年の技術哲学の文脈では、意思決定時の人間とAI技術は不可分な「合成物」である、と言います。

AIと人間の合成物による意思決定をサポートするためには、人間を説得することを狙う従来のAI技術の方向性だけでは不十分です。そこで必要になるのが、「説明可能AI」をインタラクティブ(対話的・双方向的)にすることです。インタラクティブにするとは、「説明可能AI」がユーザーに対して出した結果の根拠を説明し、ユーザー側は納得できなければAIに修正を求めるフィードバックを返せるようにするという意味です。これにより、ユーザーがAIと共に熟考を重ねた上で意思決定を行うことが可能になります。ユーザーの説得を試みるのでなく、ユーザーとのインタラクションを誘発するための説明を行う、というのが我々の考える研究の方針です(図3)。

ユーザーとインタラクションするマッチングAI:糸島市の事例

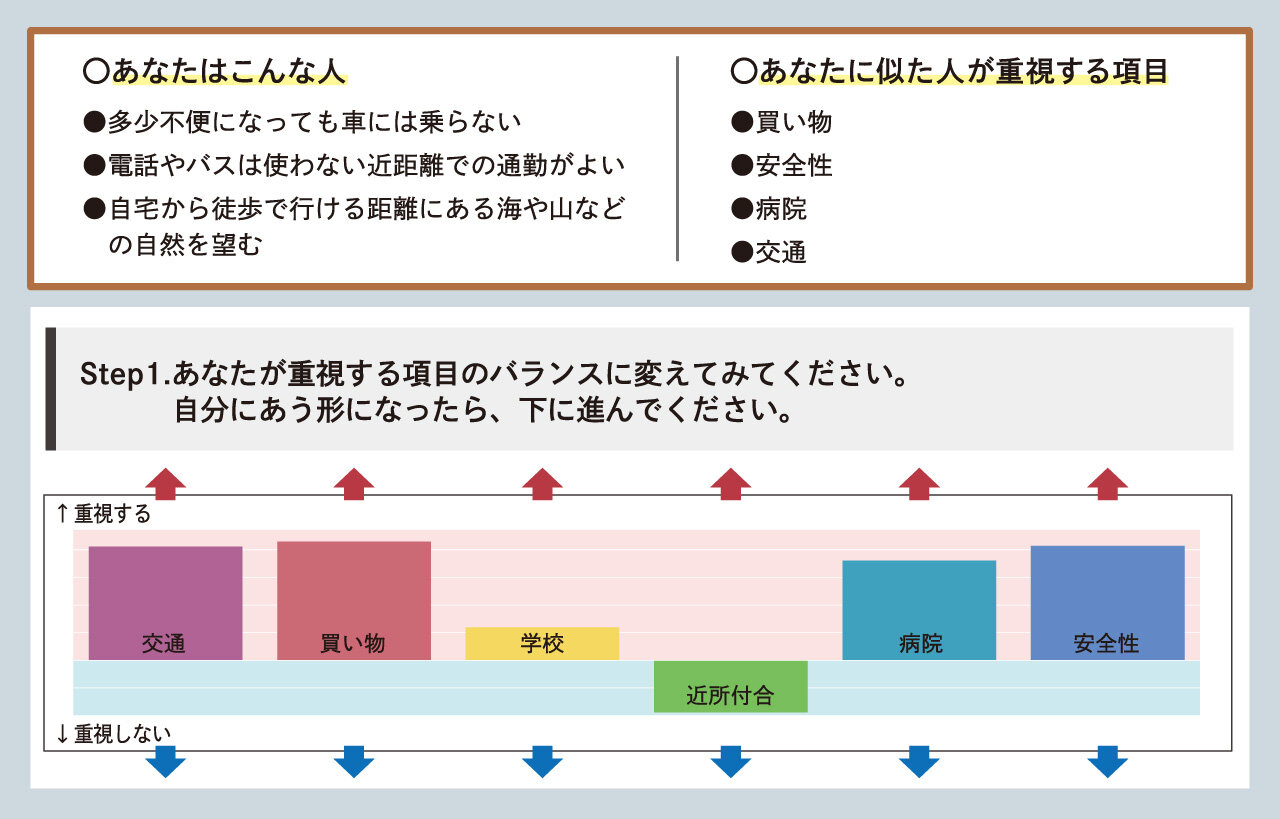

ユーザーとインタラクションするAIの一例をご紹介します。インタラクティブな「説明可能AI」のプロトタイプとして、私たち富士通研究所は福岡県の糸島市役所様と共同で、糸島市に移住したいと思う都市部に住む方に向けたマッチングAIを開発しました。都市部に住んでいる人は地方自治体の事前知識を持たないため、実際の現地の状況を学習しつつ自分が移住したい地域を探す必要があるのですが、このマッチングAIでは、糸島市内の行政区(町内会)ごとに、どの地域にユーザーが住むべきかをインタラクティブに推薦することが可能です。ユーザーへの地域推薦は、移住希望者・移住経験者の方へのインタビューに基づいて作成した病院・交通利便性・安全性といった地域指標のスコアに基づいて行われます。さらに、なぜユーザーにその地域がお薦めされているかが地域指標ごとの棒グラフとして表されます。そして、ユーザーは棒グラフを操作して値を変更することで、推薦地域のランキングを自分の希望に応じて変えていくことができます。(図4)

どの地域にその人が住むべきかをインタラクティブに推薦することが可能

また、AIの側もユーザーが変えた地域指標の重視度を基にして、ユーザーの特性を学習していきます。このシステムでは、なぜユーザーにその地域が推薦されているかが示されると同時にその根拠自体をユーザーが変更することでAIと共同で意思決定を進めていくことが可能になっています。

近年のGDPR(EU一般データ保護規則, General Data Protection Regulation)などのデータ法制では、AI技術などで自動的に行われる意思決定については、意思決定プロセスを振り返ることができる材料をユーザーに対して提示する仕組みにすることが求められています。そのため、このマッチングAIに見られるような、意思決定においてユーザー自身がフィードバックを返すのに足る情報を与える技術を開発するという流れは、次第に一般的になってくると思われます。

しかし、技術が人間からのフィードバックを受け付けるようになっても、今度は人間側がAI技術の変化に対応していく必要があります。なぜなら、人間はAIからの応答を「答え」のように見なし、真に受けてしまうことがあるからです。上記の移住マッチングAIも、実際の移住相談イベントの会場で利用してもらった際、AIから命令されたように感じるという意見をいただきました。しかし、実際にはAIの出した結果を変えることができるので、ユーザーは答えを押し付けられているわけではありません。人間は意思決定を支援してくれるAIとどう向き合っていけばいいのでしょうか。

技術の再編成の重要性

AIと向き合う際に人間側に必要になるのは、技術が出した結果を与えられた答えとして捉えるのでなく、自分で思うように改変するための仮説検証のループを回そうとする姿勢です。この姿勢はインタラクティブな「説明可能AI」が広がる前の現在であっても必要な態度です。データ駆動型の技術が主流であるからこそ、我々はAIに提示される情報を意図的に変えていくことができます。検索したり視聴するコンテンツを変えたり、トピックごとに異なるSNSのアカウントを運用することで、異なる性格をサービスごとに植え付けることが可能になります。また、このような態度を持つためには一定のリテラシーを持つことが必要です。どういうインプットを入れるとどのようなアウトプットが出てくるのか、技術を作る人であればどういう仕組みでそのサービスが動いていそうか、技術を作らない人であっても、そのサービスがもたらす影響を想像して、それに対応してどのようなポリシーで技術を使うべきかを考えることが重要です。どんな情報にさらされたとしても、なぜその情報が自分に対して提示されているのかということを常に検討していけば、技術とうまく付き合っていくことができるのではないでしょうか。

おわりに

AI技術の問題点は指摘され続けています。本稿で紹介した「説明可能AI」「公平性配慮型機械学習」のように、問題解決のために新たなAI技術が開発されています。開発が進んでも、ユーザーが何もしなくていいわけではありません。インタラクティブなAIのように、ユーザー側のフィードバックの必要な場面が出てきています。AIと離れられない現代、非専門家であっても、リテラシーを伴った仮説検証を回すことでうまくAIと付き合うことが求められます。本稿が、そうしたAIとの付き合い方を考える一助となれば幸いです。

この記事をシェアする