ナレッジ

CNNとは?機械学習の仕組みや畳み込み層・プーリング層などの構造も解説

目次

人工知能(AI)の進歩により、画像認識や音声解析など幅広い分野で「ディープラーニング」が活用されています。その代表的な手法がCNN(畳み込みニューラルネットワーク)です。

CNNは、画像や音声といった高次元データから特徴を自動的に抽出し、分類や解析を行える強力なモデルであり、AI技術の基盤となっています。

この記事では、CNNの仕組みや構造(畳み込み層・プーリング層・全結合層)を中心に、RNNとの違いやモデル設計のポイントまでを分かりやすく解説します。

CNN(畳み込みニューラルネットワーク)とは

ここでは、CNNが機械学習の中でどのような位置付けにあるのか、そして通常のニューラルネットワークとどう異なるのかを整理します。

機械学習・ディープラーニングにおける位置付け

CNNは、ディープラーニング(深層学習)で広く使われる代表的なネットワーク構造の一つです。それまでの機械学習では、画像から特徴量(エッジや模様など)を人間が手作業で設計し、それを分類器に入力するのが一般的でした。

CNNでは、この特徴量の抽出から分類までをネットワーク内部で自動的に行えることが大きな違いです。

この仕組みによって、画像認識や物体検出の精度は飛躍的に向上しました。現在では、手書き文字の識別や動物の分類といった画像処理だけでなく、音声認識や医用画像解析など、幅広い分野で実用化が進んでいます。

ニューラルネットワークとの関係性

CNNは「人工ニューラルネットワーク(Artificial Neural Network, ANN)」の一種です。通常のニューラルネットワーク(Multilayer Perceptron: MLP)は、入力層・複数の隠れ層・出力層から構成され、各ノードが全てのノードと結合しています。

しかし、画像のように扱うデータが大きい場合、全結合方式ではパラメータの数が膨大となり、学習が難しくなるという課題がありました。

この問題を解決するために考案されたのが畳み込み層を持つCNNです。画像の空間的な構造を利用し、「局所的な特徴を捉える仕組み」と「重みを共有する仕組み」によって、必要なパラメータ数と計算量を大幅に削減しています。

CNNの基本構造と仕組み

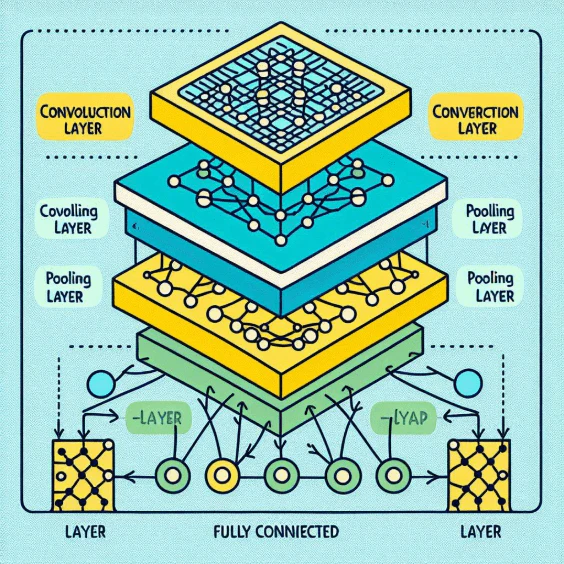

CNNは「畳み込み層」「プーリング層」「全結合層」という三つの基本的なブロックから構成されることが多いです。これらを組み合わせることで、画像や音声のデータを効率良く処理し、複雑なパターンを自動的に学習できる仕組みになっています。

ここでは、それぞれの層がどのような役割を果たしているのかを解説します。

畳み込み層(Convolutional Layer)

畳み込み層では、入力画像を小さな領域(受容野)ごとに区切り、フィルタ(カーネル)と呼ばれる小さな行列を滑らせながら演算を行います。この処理により、エッジや色の変化、模様などの局所的な特徴を自動的に抽出します。

一つのフィルタは特定の特徴を学習しますが、複数のフィルタを使うことで、画像の中から多様なパターンを同時に捉えることが可能です。その結果として得られる「特徴マップ」が次の層に渡されます(図1)。

プーリング層(Pooling Layer)

プーリング層は、畳み込み層で得られた特徴マップを縮小し、データ量を減らすことにより、ノイズに対する頑健性(位置不変性)を高める役割を担います。代表的なのが最大プーリング(MaxPooling)で、指定領域内の最大値を選び取ります。

この処理によって、

- 過学習を抑制できる

- 位置のずれや歪みに対して頑健になる

というメリットが得られます。

全結合層(Fully Connected Layer)

全結合層では、畳み込み層やプーリング層で抽出された特徴を統合し、最終的な出力(分類や回帰の結果)を導きます。全てのノードが結合しており、分類問題ではソフトマックス関数を使ってクラスごとの確率を算出するのが一般的です(図2)。

層 | 役割 | 主なパラメータ | 出力例 |

|---|---|---|---|

畳み込み層 | 局所的な特徴抽 | フィルタ数・サイズ | 特徴マップ |

プーリング層 | 特徴の集約・縮小・位置ずれへの耐性 | プールサイズ | 縮小特徴マップ |

全結合層 | 最終的な分類・回帰 | ニューロン数 | クラス確率など |

CNNの特徴と強み

CNNの最大の強みは、空間的な階層性と局所性を生かせる構造にあります。畳み込み層では「局所的な特徴」を捉え、層を重ねることで「エッジ → 模様 → 物体」といった階層的な特徴を自動的に学習します。これにより、画像認識のような複雑なタスクでも高精度を実現できます。

さらに、CNNはパラメータ共有という仕組みが利用できるため、学習に必要なデータ量が少なくても精度を出しやすく、過学習のリスクも抑えられます。

もう一つの利点は、GPUとの相性の良さです。畳み込み演算は並列処理に向いており、大規模なデータセットでも高速に学習を進められます。その結果、ImageNetのように1,000種類以上のクラスを扱う巨大な分類問題でも実用的な精度を達成できました。

これらの特徴から、CNNは「高精度」「効率性」「汎化性能」の三拍子を備えたモデルとして、ディープラーニングの中心的な存在となっています。

【比較】CNNとRNNの違い

CNNとRNNはどちらも代表的なモデルですが、処理対象や学習の仕組みに明確な違いがあります。

CNNは、画像認識や物体検出のように「空間情報」が重要なタスクで強みを発揮します。RNNは、自然言語処理や音声認識のように「順序」や「時間的依存関係」が重要なタスクで利用されます。

比較軸 | CNN | RNN |

|---|---|---|

得意分野 | 画像データ、映像、空間的な構造を持つデータ | 文章、株価などの時系列データ |

構造 | 畳み込み演算による「局所接続」と「重み共有」 | 出力を次の入力にフィードバックする「再帰構造」 |

特徴 | 位置やパターンを捉える能力が高く、階層的に特徴を抽出できる | 時間の流れに沿った情報伝達が可能 |

使い分けの例

画像の分類や物体検出ではCNNが適しており、文章生成や音声解析にはRNNが有効です。

さらに近年では、CNNとRNNを組み合わせる手法も登場しています。例えば、「画像キャプション生成」では、CNNが画像の特徴を抽出し、その情報をRNNに渡して文章を生成する、といった使い方がされています。

CNNの層数・ニューロン数の決め方

深層学習モデルを設計する際の悩みどころの一つが「層の深さ」や「ニューロン数(ユニット数)」をどのように設定するかです。CNNでは、畳み込み層やプーリング層、全結合層をどのくらい積み重ねるかによって性能や計算コストが大きく変わります。

ここでは、一般的に用いられる設計指針を整理します。

項目 | 設計の目安 |

|---|---|

畳み込み層の数 | 扱う画像サイズや抽出したい特徴の複雑さによって変化します。 |

フィルタ数(チャネル数) | 層が深くなるにつれてフィルタ数を増やすのが一般的です。例えば、第1層で32〜64チャネル、第3層以降で128〜256チャネルといった設計です。 |

プーリング層の配置 | 畳み込み層の後に定期的に挿入し、特徴マップを縮小します。全ての畳み込み層の後に置くケースも増えています。 |

全結合層の数 | 多くの場合1〜2層で十分です。必要以上に増やすと過学習のリスクが高まります。 |

最近では、データセットや計算資源に応じて最適な構造を自動探索するAutoMLやNeural Architecture Search(NAS)といった手法も登場しています。これにより、人手で設計する手間を減らしつつ、より高性能なCNNモデルを得られるようになっています。

CNNの具体的な実装例と応用

理論を理解した後は、実際にどのようにCNNを実装し、どの分野で利用できるのかを知ることが大切です。Pythonの深層学習フレームワークを使えば、CNNは数行のコードで定義でき、研究や産業の現場でも幅広く活用されています。

ここでは、代表的な実装例と応用分野を紹介します。

実装の例

Pythonでは、PyTorchやTensorFlow/Kerasといったフレームワークを使うのが一般的です。例えば、PyTorchの場合、次のようにして畳み込み層やプーリング層を定義できます。

import torch.nn as nn

model = nn.Sequential(

nn.Conv2d(in_channels=3, out_channels=32, kernel_size=3, stride=1, padding=1),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2, stride=2),

nn.Flatten(),

nn.Linear(32 16 16, 10) # 10クラス分類を想定

)

このように、CNNの基本構造はシンプルに記述でき、後はデータセットに応じて層数やユニット数を調整していきます。

応用分野の例

CNNは現在、多くの分野で実用化されています。代表的なものを挙げると、以下のとおりです。

- 医療画像診断:MRIやCT画像から病変を検出

- 製造ラインの異常検知:製品の外観検査や構造物の欠陥検出

- 自動運転:カメラ画像を用いた物体検出や車線認識

- 生物学・ライフサイエンス:顕微鏡画像による細胞分類

- 音声処理:スペクトログラムを入力として音声認識や分類に活用

画像に限らず「特徴量抽出器」としてのCNNの応用も増えており、テキストや音声と組み合わせたマルチモーダルAIの構成要素としても利用されています。

CNNと機械学習のこれから

CNNは、画像や音声といった空間情報を持つデータを扱う上で非常に強力なモデルです。畳み込み層・プーリング層・全結合層というシンプルな構造を持ちながら、局所的な特徴を階層的に抽出し、少ないパラメータで効率的に学習できる点が最大の強みです。

その柔軟性と高い精度から、医療・製造・自動運転・自然言語処理など、多様な産業分野で利用が広がっています。また、GPUや分散処理の進化により、巨大なデータセットを扱う研究でもCNNは標準的な手法となりました。

一方で、Vision Transformer(ViT)など新しいアーキテクチャも台頭しています。とはいえ、計算効率やハードウェア実装のしやすさを考えると、CNNは今後も機械学習の重要な基盤技術として使われ続けるでしょう。さらに、マルチモーダルAIやハイブリッドモデルの中で「画像側の特徴抽出器」として活用される可能性も大きいでしょう(図3)。

この記事は面白かったですか?

今後の改善の参考にさせていただきます!

-portrait.webp)